Улучшенный инструмент представлен в группе «Сканирование» на сервисе GWT (Google Webmaster Tools).

В результате выполнения соответствующих изменений владельцы сайтов смогут более оперативно обнаружить те директивы, которые блокируют заданные адреса URL. Это очень актуальный вопрос для владельцев площадок с файлами robots.txt большого объема.

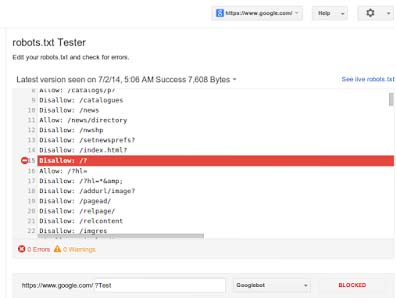

Особенности модернизированного варианта инструмента для проверки robots.txt:

- отображение строки кода, в которой присутствует запрет индексации заданной страницы;

- возможность ознакомления с добавленными ранее вариантами robots.txt с целью обнаружения случаев, когда робот не мог получить доступ к страницам сайта;

- проверка различных изменений, которые владелец внёс в robots.txt ещё до его добавления.

Согласно словам Webmaster Tools, оптимальным решением станет выполнение двойной проверки вышеупомянутого файла. Для этого можно воспользоваться иными средствами. К примеру, подойдет инструмент Fetch as Google, который расположен в группе «Сканирование». С помощью него оптимизаторы могут осуществлять просмотр страниц ресурсов, на которых опубликованы картинки, данные javascript и CSS, как это делает поисковый робот Google.

Кроме этого, эксперты поисковой системы информируют о том, что в случае выявления роботом Google внутренней ошибки 500, которая была допущена во время добавления материалов в robots.txt, алгоритм самостоятельно приостанавливает проверку ресурса.

Комментарии

-

30% отчислений вам

30% отчислений вамПартнёрка для владельцев сайтов

-

Заработок на ссылках

Заработок на ссылкахКупля-продажа эффективных ссылок

-

Биржа сайтов/каналов/групп

Биржа сайтов/каналов/группПродать сайт за 500 000 ₽? Легко!